RTX5090 체험 후기 (하) | Gcube 지큐브

이 글은 저번 체험에 대한 후기와 이어진다.

RTX5090을 사용해 Gemma3를 튜닝했었는데, 그 결과가 소실된 것을 Gcube 측에서 안타까워 하셔 체험 기회를 한번 더 제공해주셨다.

그래서 RTX5090을 3일 더 사용해볼 수 있게 되었다!

이전과 동일한 환경(Axolotl, torch On docker: ghcr.io/deveworld/gpu-dev)에서 튜닝을 진행했다.

물론 이전과 다른 점은 자체 데이터셋을 이용했다는 점이다.

AIHUB에서 제공하는 여러 한국어 코퍼스를 묶어 1차 데이터셋을 만든 후 google의 Gemini Flash 2.5 Preview를 이용해서 영어로 번역했다.

이후 원본 한국어와 영어 번역본을 합쳐 한국어-영어 데이터셋을 만들었다.

샘플링하여 확인해본 결과 AIHUB의 자체 한-영 병렬 데이터셋보다는 품질이 높았다.

물론 그렇게 고품질은 아니다. 더 정제할 시간이 부족하기도 하고 이정도면 충분하다는 생각이 들어 우선 Gemma3-1b-text에 이 데이터셋으로 파인튜닝을 진행해보았다.

(참고로 AIHUB의 자체 라이선스로 인해 데이터셋의 공개는 불가능 하다...)

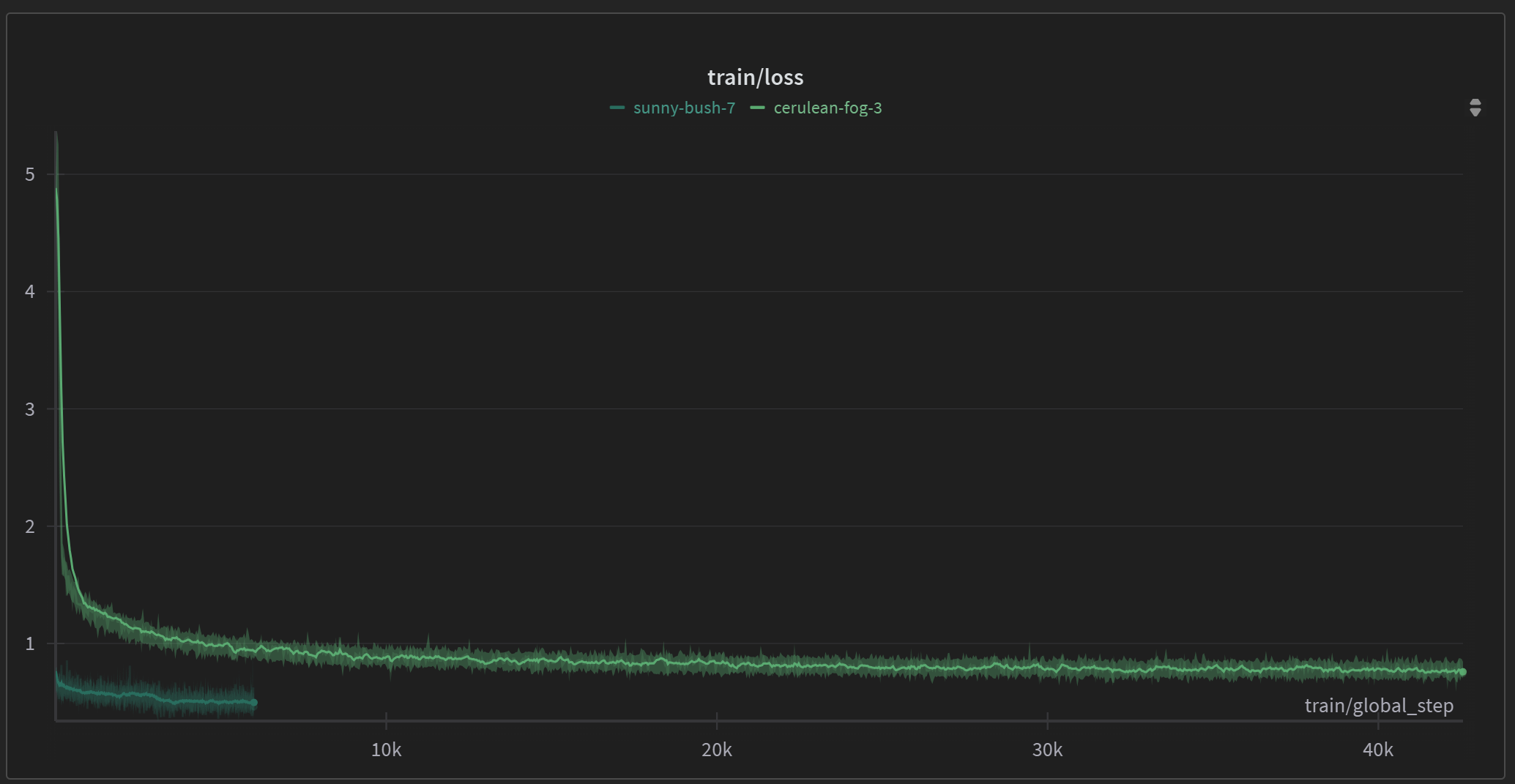

잘 학습이 되었다.

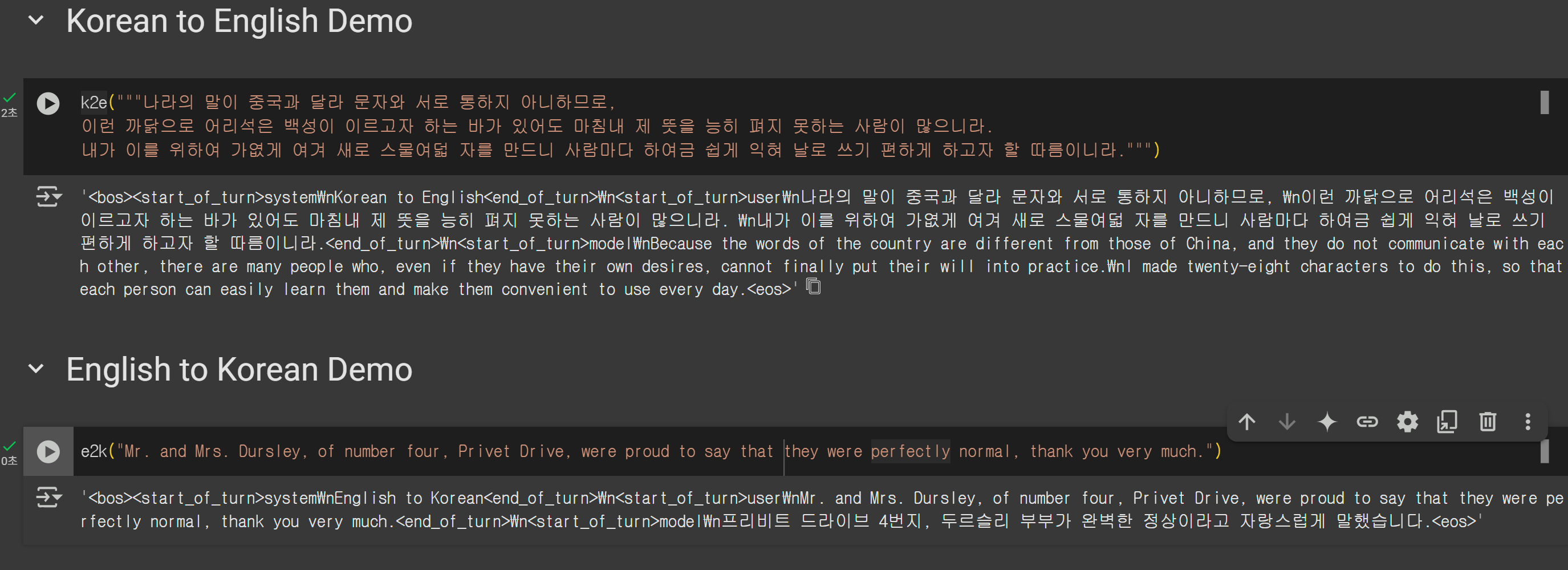

1b 모델이기에 원래 한국어 성능이 낮기도 해서 결과가 우려스러웠다. 그러나 잠깐 추론 시켜보았는데, 생각보다 성능이 괜찮아 놀랐다.

(width 이슈로 강제 개행됨)

| 원문 | 번역 |

|---|---|

나라의 말이 중국과 달라 문자와 서로 통하지 아니하므로, |

Because the words of the country |

Mr. and Mrs. Dursley, of number four, Privet Drive, |

프리비트 드라이브 4번지, 두르슬리 부부가 완벽한 정상이라고 자랑스럽게 말했습니다. |

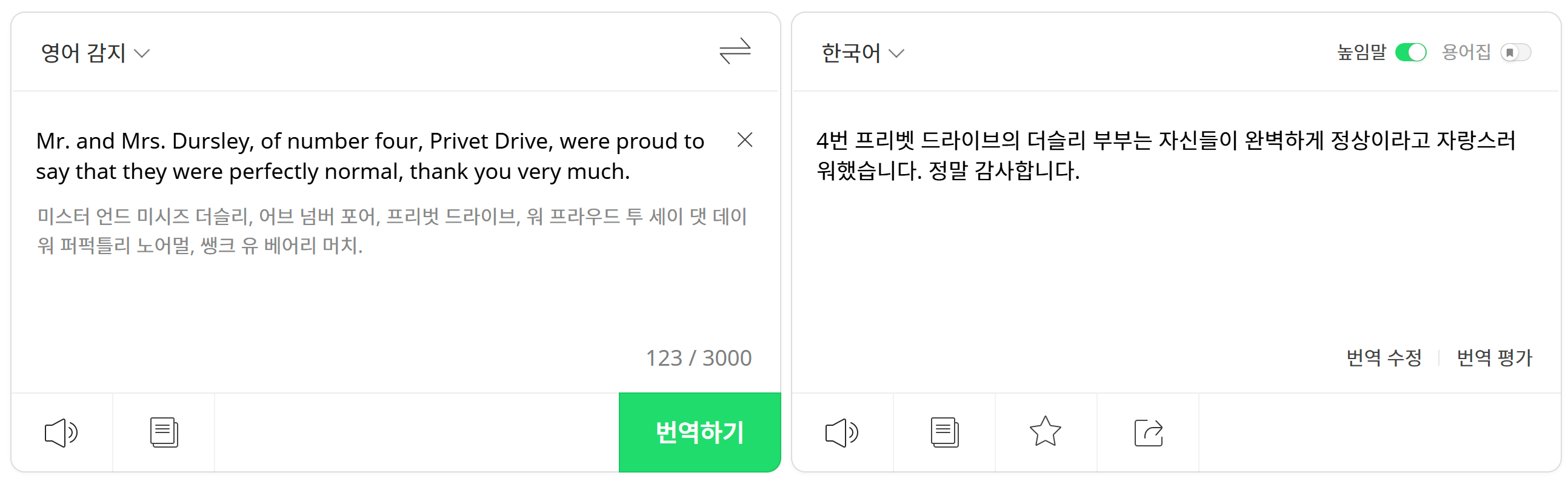

물론 가엾게 여겨나 thank you very much같은 부분을 살리지 못한 아쉬운 부분이 있지만,

파파고같은 다른 서비스에 비해서 온디바이스라는 큰 이점이 있다.

게다가 1b로 이정도 성능이고, 데이터셋도 충분히 발전할 수 있기에 많은 가능성을 열어준 테스트인 것 같다.

RTX5090에서 3일만에 1b 모델을 이렇게 파인튜닝 시킬 수 있는 것은 놀랍다고 생각한다.

이러한 실험적 테스트를 가능하게 해준 Gcube에 다시 감사의 인사를 전한다.